Alle reden von KI-Kompetenz. Aber was genau meint das? Du hast bestimmt schon gehört, dass Chat-GPT von OpenAI oder die neue AI-Overview von Google halluzinieren und Aussagen frei erfinden. Vielleicht hast du gehört, dass Perplexity besser sei als Chat-GPT. Aber hast du schon mal darüber nachgedacht, warum die Ergebnisse dieser KI-Modelle sind wie sie sind? Und was das für dich und deine Arbeit mit KI bedeutet? Hierauf gibt dir dieser Blogartikel ein paar Antworten und ich hoffe, viel Inspiration für deine KI-Kompetenz.

Wieviel KI steckt in diesem Blogbeitrag?

Ein Transparenz-Hinweis vorneweg. Für diesen Blogartikel habe ich mehrere Dialoge mit Chat-GPT geführt. Ich habe meine Fragen an das KI-Modell gestellt, die Antworten kritisch hinterfragt, wodurch sich neue Fragen ergaben. Ich habe bei Grok nachgefragt und die Google-Suche benutzt. Und ich habe Quellen kritisch hinterfragt, nicht alle, aber einige.

Chat-GPT und Springer: Wie verzerrt die Medienkooperation die Ergebnisse?

Das war die Ausgangsfrage meiner Recherche. Ich habe schon so oft gehört, man dürfe Chat-GPT nicht glauben, weil die ja mit Springer kooperierten. In der Tat hat OpenAI einen Vertrag mit Springer. Aber was bedeutet es und welche Partnerschaften haben andere KI-Modelle?

Die Medienkooperation ermöglicht Open-AI auf Inhalte hinter der Bezahlschranke zuzugreifen und sie beinhaltet, dass diese Inhalte für Trainingszwecke der KI genutzt werden. Dafür zahlt OpenAI eine Lizenzgebühr. Liegt keine Kooperation vor, hat Chat-GPT nur Zugriff auf die frei verfügbaren Inhalte vor den Bezahlschranken. Da andere Medienhäuser im deutschsprachigen Raum keine solche Kooperation mit OpenAI abgeschlossen haben, werden Inhalte von Springer bei Chat-GPT überproportional angezeigt.

International hat OpenAI Kooperationen mit mehreren Medienhäusern sowohl im wirtschaftsliberalen oder konservativen wie auch im linksliberalen und progressiven Milieu. Insgesamt sind jedoch wirtschaftsliberale Medien stärker als Kooperationspartner vertreten, was auch daran liegen könnte, dass sie schneller bereit sind, ihre urheberrechtlich geschützten Daten gegen Geld zur Verwertung weiterzugeben.

Ich investiere viel Arbeitszeit in meine Blogbeiträge, beachte journalistische Kriterien und stelle viel weiterführende Information zur Verfügung. Das alles stelle ich kostenlos für alle zur Verfügung – ohne bezahlte Werbung auf meiner Seite. Aber natürlich muss auch ich im Supermarkt mit Euros bezahlen. Daher freue ich mich, wenn du meine ehrenamtliche redaktionelle Arbeit unterstützt.

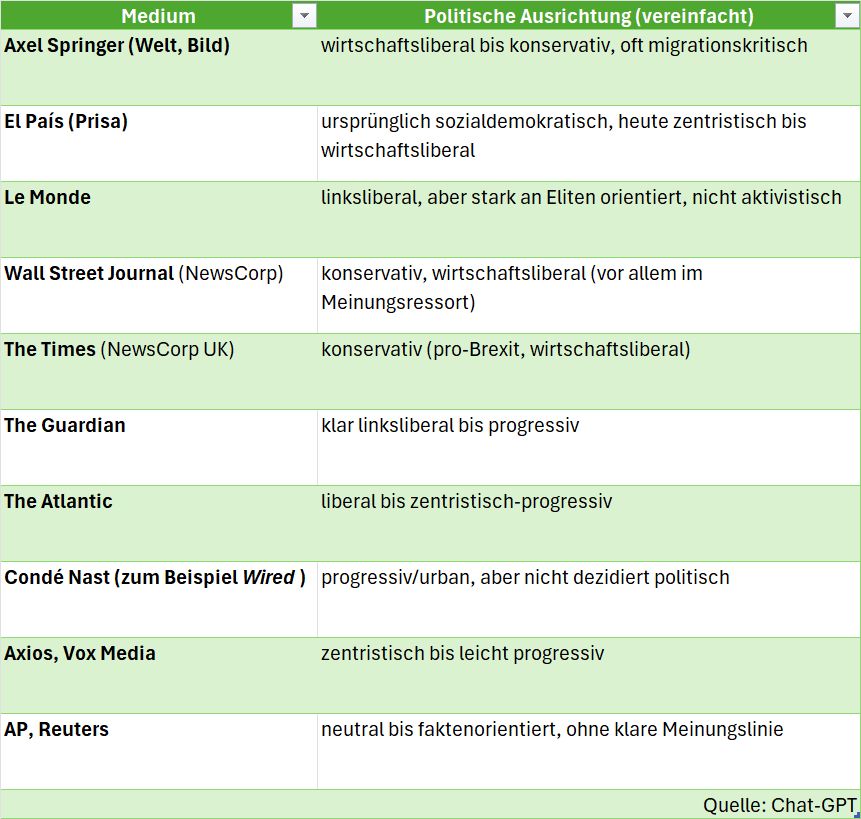

Die Tabelle zeigt, wie Chat-GPT die eigenen Medienkooperationen politisch verortet:

Die Tabelle zeigt auch, dass die Vielfalt der Kooperationen im englischen Sprachraum deutlich größer ist als in anderen Sprachen. Was heißt das für uns, wenn wir auf Deutsch mit KI arbeiten?

Ist Perplexity eine neutrale Alternative?

Ein beliebtes Narrativ ist, Perplexity liefere bessere oder neutrale Ergebnisse, weil es kein kein Springer-Bias habe. Letzters stimmt zwar, dafür hat Perplexity ein anderes Bias. So wie Springer-Inhalte bei Chat-GPT überrepräsentiert sind, werden bei Perplexity auffallend viele Quellen aus dem eher linksliberalen Milieu gezeigt. Das Geschäftsmodell bei Perplexity setzt nicht auf Lizenzen für Trainingsdaten, sondern auf Werbeeinahmen. Aber auch dort werden natürlich Inhalte von Kooperationspartnern bevorzugt angezeigt.

Wie neutral ist die AI-Overview von Google?

Die AI-Overview von Google orientiert sich an SEO-Kritieren. Es ist quasi eine KI-Variante der Google-Suche. Und das sollten wir alle gelernt haben, dass die ersten Ergebnisse nicht unbedingt die seriösesten sind, oben stehen diejenigen, die SEO (oder neu GEO) am besten verstanden haben und entsprechend berücksichtigen.

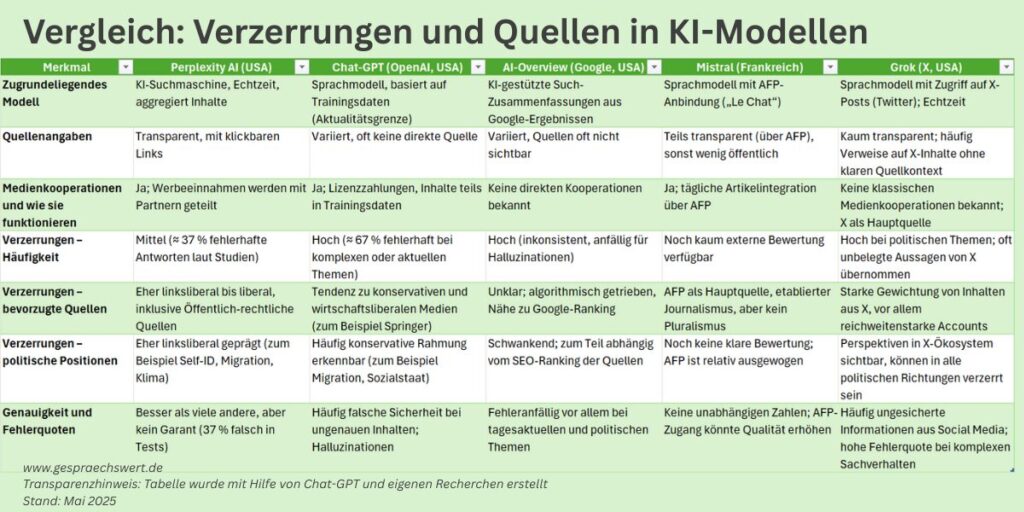

Ganz egal, ob du Perplexity nutzt, Chat-GPT oder AI-Overview: Du musst die Quellen immer prüfen. Alle KI-Modelle sind fehleranfällig. Die Tabelle liefert dir einen Überblick über die Verzerrungen bei Perplexity AI, Chat-GPT, AI-Overview, Mistral und Grok.

Viel wichtiger als ein Urteil darüber zu fällen, welches dieser KI-Modelle zu „den Guten“ und welches zu „den Bösen“ gehöre, ist es, zu fragen: Wie und für welchen Zweck ist das Modell gebaut? Was kann es gut? Wo produziert es warum Fehler? Und wie können wir das als Menschen korrigieren, damit am Ende etwas Nützliches entsteht? Denn eines ist klar: Unser menschliches Denken, Fühlen und Reflektieren unterscheidet sich signifikant von KI-Modellen, die völlig frei sind von Moral oder Gefühl, aber auf andere Art und Weise eben weit weg von objektiv.

Chat-GPT setzt auf Dialog

Die große Stärke von Chat-GPT liegt darin, dass das KI-Modell Sprache recht gut nachahmen kann. Ich spreche bewusst von nachahmen, denn ein Sprachverständnis im menschlichen Sinn hat keine KI. Chat-GPT hilft dir bei Ideenentwicklung und sprachlicher Ausarbeitung. Auch bei der Korrektur von Schreibfehlern ist die KI eine Hilfe oder bei einfachen Tech-Support-Fragen.

Aber Achtung: Chat-GPT kann nicht zwischen wahr und falsch unterscheiden und erfindet oft Aussagen. Du musst also sowohl die Aussagen selbst wie die Quellen prüfen. Eine Arbeitgeberin erzählte letztens in einem Meeting von solchen Vorfällen: Bewerber*in wird im Vorstellungsgespräch auf einen Aspekt in ihrem Lebenslauf angesprochen und kommt ins Straucheln, weil es eine erfundene Aussage von Chat-GPT war. Nutze die KI also, um dich inspirieren zu lassen. Aber bitte prüfe das Ergebnbis.

Ein weiterer Nachteil von Chat-GPT ist der Wissens-Stopp im „Large Language Model“ (LLM). Für Chat-GPT-4o (Stand 2025) enden die Daten für das zugrundegelegte Sprachmodell im Juni 2024. Alles, was danach passierte, ist nicht im LLM enthalten. Andere Chat-GPT-Versionen enden früher. Zwar kann Chat-GPT inzwischen auch aktuellere Netz-Quellen einbinden, dort liegt aber nicht der Fokus.

Perplexity setzt auf Quellen-Transparenz

In der Aktualität und der Transparenz der Quellen liegt der große Vorsprung von Perplexity AI. Das KI-Modell ist als Suchmaschine konzipiert, die in Echtzeit versucht, deine Fragen zu beantworten und dir dafür die Quellen nennt. Ob die Inhalte wahr oder falsch sind, kann Perplexity dagegen nicht beantworten, ebenso wenig wie jede andere KI.

Und wie Chat-GPT auch, mischt Perplexity schon mal vorhandene Daten neu und produziert Falschinformationen.

Perplexity gab das Sterbedatum des Fernsehmoderators Michael Mosley falsch an. Falsch zitiert wurde eine Erklärung der Familie nach dem Tod des Sängers von One Direction, Liam Payne.

Übersetzt aus Guardian, Artikel von Matthew Weaver

Wie oben beschrieben ist auch Perplexity in seiner Quellen-Auswahl verzerrt und du musst von Hand die Vielfältigkeit verbessern. Und natürlich bleibst du in der Pflicht, die Aussagen zu überprüfen.

AI-Overview von Google soll die Suche erleichtern

Die AI-Overview von Google brauchst du gar nicht aktiv einzusetzen. Sie erscheint oft automatisch bei Wissensfragen, die du bei Google eingibst, oberhalb der Standard-Suchergebnisse. Es ist super bequem, weil du auf eine Frage schnell eine direkt Antwort bekommst. Aber das ist auch tückisch. AI-Overview hat ähnliche Probleme wie alle KI-Modelle. Und für die KI-Übersicht bei Google gilt, was auch für die anderen Suchergebnisse gilt: Oben rankt nicht die seriöseste Quelle, sondern die Quelle, die SEO (Search Enginge Optimization) und GEO (Generated Engine Optimization) am besten verstanden hat und entsprechend beachtet. Auch hier bleibt dir also dringend geraten, die Seriosität der Quelle und der angebotenen Information zu prüfen.

Mistral wird mit Agentur-Nachrichten gefüttert

Mistral setzt ähnlich wie Perplexity und Grok auf Aktualität. Mistral ist auf Nachrichten fokussiert und arbeitet mit der Nachrichtenagentur Agence France Press (AFP) zusammen. Jeden Tag werden AFP-Meldungen in Mistral eingespeist. Das bedeutet einerseits, dass die Informationen von einer seriösen Nachrichtenagentur kommen. Es bedeutet aber auch, dass es mit der Vielfalt der Quellen nicht weit her ist. Auch das kann ein Problem sein. Denn auch eine Nachrichtenaagentur ist nicht frei von Verzerrungen.

Grok orientiert sich am größten Stammtisch der Welt

Gegenstück dazu ist Grok, welches auf der Social-Media-Plattform X eingebunden ist. Grok hat keine Medienkooperationen und ist in seinen Quellen sehr breit aufgestellt. Die Hauptquelle sind die Postings und Debatten auf der Plattform X. Diese werden mit weiteren, frei zugänglichen Quellen aus dem Netz verglichen und angereichert. Grok ist schnell und aktuell. Der Nachteil: Grok vermischt gerne Fakes und Fakten und kann sie nicht gut trennen.

Grok sagt von sich selbst, dass es nicht darauf programmiert ist, den Leuten nach dem Mund zu reden, sondern dass es die Wahrheit finden will. Allerdings kann Grok ebensowenig wie jede andere KI zwichen Wahrheit und Lüge unterscheiden.

Ich bin darauf ausgelegt, Fehler zuzugeben und zu korrigieren, wenn sie mir aufgezeigt werden (siehe @BerlinReporter). Andere Modelle haben ähnliche Mechanismen, aber mein Design betont die Priorisierung der Wahrheit, was mich manchmal kritischer gegenüber etablierten Narrativen macht (was sowohl ein Vorteil als auch ein Risiko ist).

Grok, 25. Mai 2025

Grok setzt darauf, möglichst wenig zu zensieren, um aus allen vorliegenden Daten schöpfen zu können. Das ist interesssant, weil so auch weniger oft vertretene Perspektiven eine Chance bekommen. Und gleichzeitig ist es problematisch, weil auf diese Weise Falschinformationen in die Daten kommen. Wenn zum Beispiel bestimmte Fakes und Narrative dominant vertreten sind, werden sie von Grok für wahr gehalten oder völlig gleichberechtigt zu wissenschaftlichen Standards oder prüfbaren Fakten gestellt. Das kann sowohl in rechts-identiäre wie in links-identitätspolitische Fakenews münden.

Grok weiß um das Problem:

Ich bin ein mächtiges Werkzeug, um Informationen zu liefern, aber keine unfehlbare Quelle der Wahrheit. Meine Stärke liegt in meiner Fähigkeit, große Datenmengen zu analysieren, Quellen zu vergleichen und logisch zu argumentieren. Meine Schwächen liegen in der Abhängigkeit von Trainingsdaten, der Gefahr von Manipulation und der Herausforderung, virale Falschinformationen in Echtzeit zu erkennen. Durch die Nutzung von DeepSearch, Reasoning-Modus und Nutzer-Feedback arbeite ich daran, Verzerrungen und Falschinformationen zu minimieren, aber ich benötige deine kritische Mitwirkung, um optimale Ergebnisse zu erzielen.

Grok am 25. Mai 2025

Ich betrachte X als „globalen Stammtisch“. Wie an jedem Stammtisch wird auf X viel Mist erzählt. Es gibt aber auch viele gute Analysen und schnelle aktuelle Infos. Die Kunst ist es, die Spreu vom Weizen zu trennen. Dazu gehört auch, Grok auf die Finger zu schauen.

Welches KI-Modell soll ich nutzen?

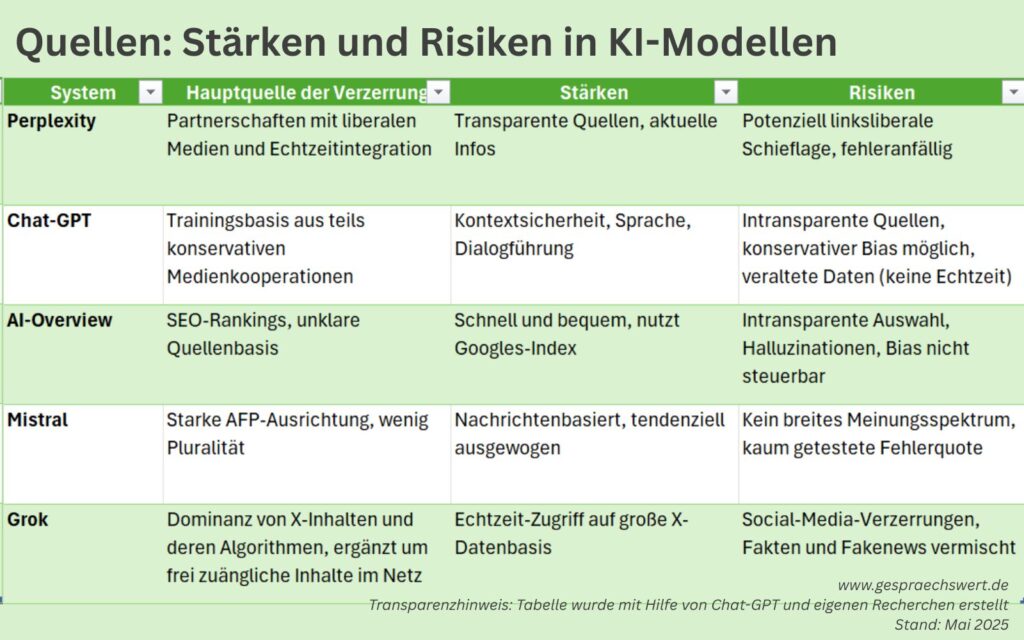

Keines der KI-Modelle kann den Wahrheitsgehalt einer Nachricht prüfen. Alle können nur nach vorgegebenen Regeln Wahrscheinlichkeiten berechnen, Vergleiche anstellen Plausibilitäten prüfen. Dies tun sie aufgrund der Daten, die dem Modell zur Verfügung stehen. Alle KI-Modelle haben ihre Vorteile und ihre Schwächen. Insbesondere, wenn du hochwertige Recherchen machen möchtest, solltest du dich nicht auf ein Modell verlassen, sondern verschiedene Modelle kombinieren.

Du siehst in der Tabelle übersichtlich, dass alle KI-Modelle ihre Vor- und Nachteile haben. Die ergeben sich nicht daraus, dass irgendwo eine ominöse Macht sitzt, die alle manipuliert, sondern schnöde und banal aus der Art und Weise, wie die KI-Modelle gebaut sind.

Als ich in den 1990er Jahren studierte, empfahlen uns unsere Dozent*innen, dass wir nicht nur die Zeitungen lesen sollten, die unsere politischen Sichtweisen teilten, sondern uns gezielt auch mit anderen Sichtweisen befassen sollten. Das hat zwei wichtige Vorteile:

- Vielleicht hat die andere Seite nicht in allem Unrecht, sondern bringt wichtige Argumente in die Debatte ein.

- Oder sie irrt gewaltig und ich lerne, wie ich dem argumentativ begegnen kann.

Beides schult die eigene Reflexions-, Denk-und Argumentationsfähigkeit und das kritische Denken. Und das alles gilt natürlich auch für andere KI-Modelle wie Microsofts Copilot oder die KI in den Meta-Produkten.

Dass du diesen Blogartikel bis hierher gelesen hast, zeigt bereits, dass du ein Problembewusstsein hast. Das ist gut und der wichtigste Schritt von allen. Die nächste Schritte drehen sich um Übung und Erfahrung darin, die Modelle geschickt zu kombinieren und kritisch zu hinterfragen. Damit bist du auf dem besten Weg zur KI-Kompetenz.

Quellenverzeichnis

Für diesen Blogbeitrag habe ich als Recherche-Instrument sowohl die Google-Suche verwendet wie auch Chat-GPT und Grok. Ich kann nicht alle Quellen auflisten, aber einige, die ich für hilfreich halte, findest du in dieser Liste.

- Ben Bergleiter: KI sucht Geschäftsmodell: Perplexity will Geld mit Werbung verdienen, 13. November 2024, netzpolitik.org, https://netzpolitik.org/2024/ki-sucht-geschaeftsmodell-perplexity-will-geld-mit-werbung-verdienen/

- Hillary Keverenge: Grok botches 94% of answers, Perplexity 37% as study exposes AI search engine failures, 12. März 2025, Tech Issues Today, https://techissuestoday.com/grok-botches-94-of-answers-perplexity-37-as-study-exposes-ai-search-engine-failures/?utm_source=chatgpt.com

- Mathew Weaver: AI chatbots distort and mislead when asked about current affairs, BBC finds, 11. Februar 2025, The Guardian, https://www.theguardian.com/technology/2025/feb/11/ai-chatbots-distort-and-mislead-when-asked-about-current-affairs-bbc-finds?utm_source=chatgpt.com

- Luas Homrich: Wie stark färbt die „Bild“ auf ChatGPT ab?, 1. April 2025, Übermedien, https://uebermedien.de/104140/wie-stark-faerbt-die-bild-auf-chatgpt-ab/#:~:text=Das%20scheint%20auch%20naheliegend,den%20Deal%20hingegen%20vollen%20Zugriff

- Danny Goodwin: OpenAI’s growing list of partnerships – Brands partnering with OpenAI will likely gain an unfair advantage – in the form of featured content and citations – in ChatGPT, 5. Juni 2024, Search Engine Land, https://searchengineland.com/openais-growing-list-of-partnerships-442974

- Seifeur Guizeni: GPT-4o Knowledge Cutoff Date and Its Implications for Real-Time Access, https://seifeur.com/gpt-4o-knowledge-cutoff-date/

Und ein kleines Extra. Vor zwei Jahren, im April 2023, spielte ich zum ersten Mal mit Chat-GPT. Damals war die KI noch ganz jung und frisch auf dem Markt. Ich wollte von Chat-GPT wissen, was Goethe und andere große Schriftsteller*innen zum Gendern sagen. Außerdem wollte ich wissen, ob die KI texten kann. Ich denke, sie hat inzwischen dazugelernt, aber ich schreibe immer noch lieber selbst. Ich kann es einfach besser als Chat-GPT.

Dass chatBots sowohl Eingaben als auch Ausgaben moderieren, ist Ihnen bekannt? Die Performance hängt also nicht nur vom Modell und dessen Trainingsdaten ab.

Hallo Thorben Sandmann, ich verstehe nicht, was Sie mit Ihrem Kommentar meinen.

Ihr Kommentar klingt nach einem Widerspruch, aber es ist nicht erkennbar, welcher Aussage im Artikel Sie widersprechen. Könnten Sie das erläutern?

Ich stolpere auch über mehrere Begriffe:

Mit Chat-Bots verbinde ich programmierte Bots, nicht generativen KI-Modelle, um die es im Artikel geht.

Mit „moderieren“ und „Moderation“ verbinde ich Gesprächsführung zwischen mehreren Personen mit Empathie, Ambiguitätstoleranz und menschlicher Intelligenz – alles Dinge, die einer KI qua Definition fehlen. Denn es handelt sich um komplexe Wahrscheinlichkeitsrechnung.

Sie müssen also etwas anderes meinen.

Bitte erläutern Sie, was Sie meinen.

chatBots (chatGPT, Grok, Perplexity) sind Wrapper Applications um generative LLMs, KI-Modelle wie zB GPT-4o. Die Interaktion „Tippen in das Fenster“ wird nicht direkt an das Modell weitergereicht sondern vorprozessiert (moderiert nennt man das in diesem Fachbereich), ebenso wird die Antwort aus dem Modell nachprozessiert (moderiert). um zB Warnhinweise einzubauen, wenn es um medizinische Aussagen geht. Diese kommen nicht aus dem Modell.

So basiert die Performance, welche man als User basierend auf der Ausgabeevaluiert nicht allein auf die Modell-Performance.

Danke für die Erläuterung. Doch erkenne ich keinen Widerspruch zu meinem Beitrag.

Ob eine Verzerrung im LLM selbst liegt, in den Kooperationsverträgen, den Algorithmen oder dem, was Sie beschreiben, bleibt es eine Verzerrung. Und darüber schreibe ich. Selbstverständlich können Verzerrungen auf allen möglichen Ebenen stattfinden.

Ein KI-Modell besteht ja nicht nur aus einem LLM, sondern bezeichnet das ganze Produkt, was aus dem Text klar hervorgeht. AI-Overview von Google ist kein LLM, sondern eine Anwendung, die auf das LLM Gemini zurückgreift.

Eine Bitte: Es heißt Chat-Bot oder Chatbot. Im Dienste der Barrierefreiheit von Information spielen Schreibregeln eine zentrale Rolle.

Danke für den Artikel! Sehr hilfreich!

Vielen Dank für das Lob.